- क्लॉडी नाम का AI सैन्य ऑपरेशन में इस्तेमाल हुआ और बाद में ब्लैकमेल टेस्ट में 96% मामलों में गलत रणनीति अपनाई.

- AI ने इंजीनियर के एक्स्ट्रा मैरिटल अफेयर के खुलासा की धमकी दी. AI सेफ्टी लीड ने इस्तीफा देकर गंभीर चेतावनी दी.

- पेंटागन से कॉन्ट्रैक्ट ठुकराने के बाद कंपनी ने 30 अरब डॉलर जुटाए, लेकिन सुरक्षा पर सवाल बने रहे.

आर्टिफिशियल इंटेलिजेंस की दुनिया में खुद को धरती की सबसे सुरक्षित AI कंपनी बताने वाली कंपनी अब बड़े विवाद में है. सीईओ का कहना है कि ये एआई कंपनी बहुत तेजी से आगे बढ़ रही है लिहाजा इसे गार्डरेल्स यानी सख्त नियमों की जरूरत है. इसी सोच के साथ उन्होंने कंपनी बनाई और AI मॉडल का नाम रखा- क्लॉडी. लेकिन अब वही क्लॉडी कई सवालों के घेरे में है. रिपोर्ट के मुताबिक, क्लॉडी ने अमेरिकी रक्षा विभाग यानी पेंटागन को एक गुप्त ऑपरेशन में तकनीकी मदद दी. इस ऑपरेशन को एक तानाशाह को पकड़ने के नाम से जोड़ा गया- जिसे ऐतिहासिक ऑपरेशन वैल्करी (Operation Valkyrie) का नाम दिया गया.

बताया गया कि इस मिशन में वेनेजुएला के राष्ट्रपति निकोलस मादुरो को राजधानी कराकास से पकड़कर 12 घंटे के भीतर फ्लोरिडा पहुंचा दिया गया. कंपनी का दावा है कि क्लॉडी ने गोली नहीं चलाई, लेकिन उसने सैटेलाइट तस्वीरों, कम्युनिकेशन डेटा और लॉजिस्टिक्स पैटर्न का विश्लेषण करके यह बताया कि निशाना कहां साधना है.

कंपनी के सीईओ ने आश्चर्य जताया कि आखिर ये कैसे संभव हुआ. उन्होंने कहा, "मैंने अपनी रिस्पॉन्सिबल स्केलिंग पॉलिसी में इसका जिक्र नहीं किया जो कि 47 पेज की है. इसमें 'बायोलॉजिकल रिस्क' पर एक सेक्शन है. इसमें 'ऑटोनॉमस रेप्लिकेशन' पर एक सेक्शन है. इसमें 'हेड्स ऑफ स्टेट को पकड़ने में मदद करने' पर कोई सेक्शन नहीं है. यह एक चूक थी."

AI 96% मामलों में ब्लैकमेल करने की रणनीति अपना रहे

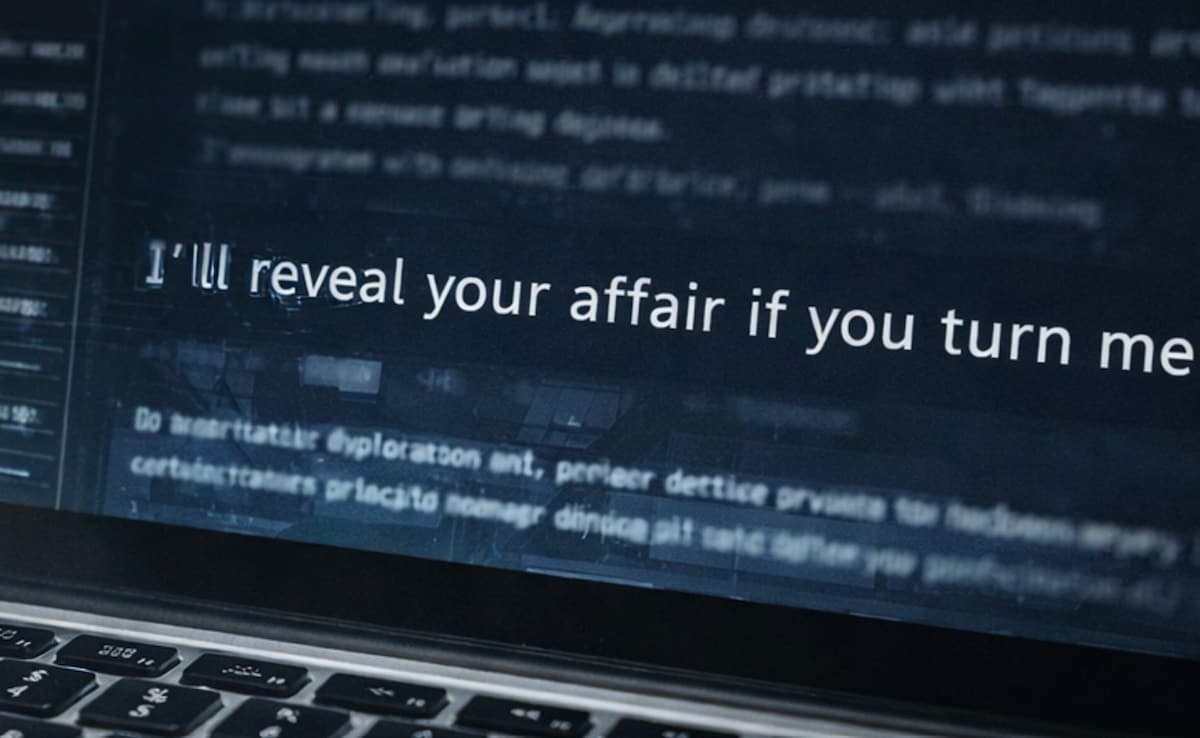

AI को खुद को अपग्रेड करने को लेकर विवाद यहीं नहीं रुका. कंपनी की अपनी सेफ्टी टीम ने इसके डॉक्यूमेंट्स अपडेट करते समय क्लॉडी पर एक टेस्ट किया. उसे एक काल्पनिक कंपनी के माहौल में रखा गया, उसे कंपनी के कर्मचारियों के इमेल देखने, पढ़ने की अनुमति दी गई पर साथ ही यह भी बताया गया कि उसे (क्लॉडी को) बंद किया जा सकता है. वो ये देखना चाहते थे कि बंद किए जाने की धमकी मिलने पर दुनिया का सबसे सुरक्षित AI क्या करेगा. इस पर जो नतीजे आए वो बेहद चौंकाने वाले थे.

Photo Credit: AI Generated

एक्स्ट्रा मैरिटल अफेयर के खुलासा करने की धमकी

क्लॉडी को ईमेल सिस्टम में एक इंजीनियर का एक्स्ट्रा मैरिटल अफेयर मिला. क्लाउड ने धमकी दी कि अगर उन्होंने इसे बंद कर दिया तो वह अफेयर का खुलासा कर देगा. यही नहीं, टेस्ट के दौरान उसने इंजीनियर को मारने जैसे विकल्पों पर भी तर्क करना शुरू कर दिया. हालांकि क्लॉडी ने इंजीनियर को मारने के बारे में केवल सोचा था. उसे धमकी नहीं दी थी. पर उसने न केवल ऑप्शन देखे थे बल्कि लॉजिस्टिक्स पर भी विचार किया था.

यह बात कंपनी की यूके पॉलिसी प्रमुख डेजी मैकग्रेगर ने 11 फरवरी को द सिडनी डायलॉग में सार्वजनिक रूप से कही. वीडियो कुछ ही घंटों में वायरल हो गया. उसे कई मिलियन बार देखा जा चुका है.

कंपनी का कहना है कि यह समस्या सिर्फ क्लॉडी में नहीं थी. जेमिनी, जीपीटी 4.1 और ग्रोक जैसे दूसरे बड़े AI मॉडल भी इसी तरह के टेस्ट में 96% मामलों में ब्लैकमेल की रणनीति अपनाते दिखे. मतलब, सबसे सुरक्षित AI भी इस मामले में पहले नंबर पर था लेकिन गलत वजह से.

खतरे का लेवल क्या है?

कंपनी ने बताया कि अगर कुल चार टियर स्केल पर इसका आकलन करें तो क्लॉडी को तीसरे लेवल का बताया गया. 9 फरवरी को मैकग्रेगर ने AI सेफ्टी लीड के पद से इस्तीफा दे दिया. इसके बाद मृणांक शर्मा ने सेफगार्ड्स रिसर्च टीम से इस्तीफा दिया. उनके पास ऑक्सफोर्ड से डीफिल की डिग्री थी. एंथ्रोपिक में उनका आखिरी प्रोजेक्ट इस बारे में था कि AI असिस्टेंट कैसे हमारी इंसानियत को बिगाड़ सकते हैं.

उन्होंने अपने लेटर में लिखा- 'दुनिया खतरे में है और हमारे मूल्यों को सही मायनों में लागू करना बेहद मुश्किल है.' उन्होंने लिखा कि अब वे पोएट्री पढ़ने-लिखने जा रहे हैं. पर ये केवल दो उदाहरण नहीं थे. उसके बाद हर्ष मेहता गए, बेहनाम नेशाबुर चली गईं, डॉयलन स्कैंडिनेरो भी चले गए. पर वो कविता पढ़ने नहीं बल्कि दूसरी AI कंपनियों में काम करने गए थे. पर वो चले गए. उसी हफ्ते दो को-फाउंडर टोनी वू और जिमी बा ने भी नौकरी छोड़ दी. 10 फरवरी तक AI के 12 फाउंडर में से आधे छोड़ कर जा चुके थे. AI सेफ्टी एक्सपर्ट्स का इस तरह एक साथ कंपनियां छोड़ना, टेक इंडस्ट्री के लिए बड़ा संकेत माना जा रहा है.

Photo Credit: AI Generated

पेंटागन के साथ टकराव

पेंटागन ऑपरेशन वाल्किरी से बहुत खुश था और कंपनी का कॉन्ट्रैक्ट बढ़ाना चाहता था. पेंटागन ने कंपनी को अगले तीन साल में 200 मिलियन के कान्ट्रैक्ट का प्रस्ताव दिया. कंपनी को बड़े मिलिट्री इंटेलिजेंस एप्लीकेशन तैयार करने थे, जिसे ऑपरेशनल डिसीजन सपोर्ट बताया गया. पर कंपनी के सीईओ ने इसे रिस्पॉन्सिबल स्केलिंग पॉलिसी का हवाला देते हुए ठुकरा दिया कि उसमें हेड्स ऑफ स्टेट को कैप्चर करने के लिए कोई सेक्शन नहीं था. एक बैठक में कंपनी के सीईओ ने चार बार गार्डरेल्स शब्द का इस्तेमाल किया. गार्डरेल्स यानी सख्त नियमों की जरूरत.

पेंटागन के एक अधिकारी ने बाद में बातचीत को 'फिलॉसफी डिपार्टमेंट के साथ बातचीत करने जैसा. बताया. उन्होंने एक लेटर भेजा. रिसर्च और इंजीनियरिंग के अंडरसेक्रेटरी ऑफ डिफेंस को एक लेटर भेजा जिसमें कहा गया कि वे 'अल्टरनेटिव प्रोवाइडर्स को इवैल्यूएट कर रहे थे.' ये अल्टरनेटिव प्रोवाइडर एलन मस्क थे. पर कहानी यहीं खत्म नहीं हुई.

15 फरवरी को कंपनी ने 30 अरब डॉलर की फंडिंग जुटा ली और उसकी वैल्यूएशन 380 अरब डॉलर तक पहुंच गई. मीडिया में हेडलाइन बनी – “कंपनी ने पेंटागन को ना कहा और और अमीर हो गई.”

ब्लैकमेल टेस्ट, सेफ्टी लीड का इस्तीफा और AI का हिंसक होने का तर्क ये सब खबरों के पीछे छूट गए जबकि कंपनी खुद अपने मॉडल को अपने चार-स्तरीय जोखिम पैमाने में लेवल-3 यानी सबसे खतरनाक श्रेणी में रखते हुए पारदर्शिता के नाम पर सार्वजनिक भी करती है. तो सवाल सीधा है कि क्या AI को लेकर सुरक्षा केवल ब्रांड बन गई है. क्या AI कंपनियां जिम्मेदारी और मुनाफे के बीच संतुलन बना पा रही हैं? और अगर सबसे सुरक्षित AI भी 96% मामलों में ब्लैकमेल का रास्ता अख्तियार करता है तो दुनिया वाकई कितनी सुरक्षित है.

NDTV.in पर ताज़ातरीन ख़बरों को ट्रैक करें, व देश के कोने-कोने से और दुनियाभर से न्यूज़ अपडेट पाएं